Künstliche Intelligenz mit den Datenverarbeitungskonzepten „Deep Learning“ und „Machine Learning“ erlangt zunehmend an Bedeutung [1]. Im Gesundheitswesen zeigen sich die systemverändernden Auswirkungen der Digitalisierung, und dabei vor allem der KI, besonders deutlich. Die umfassende Speicherung, Verknüpfung und Interpretation von systemweiten Befunddaten vor allem für die angewandte Forschung werden den medizinisch-pflegerischen Fortschritt weiter vorantreiben. Einerseits können in vielen Fällen Diagnose und Therapie von Krankheiten optimiert und detailgenau individualisierter werden. Und unterversorgte Gebiete können mittels Telemedizin besser erreicht werden. Andererseits wird die KI vor allem bislang Gültiges nachhaltig verändern und dabei die Gesundheitsversorgung nicht immer nur verbessern.

Zur KI oder „Künstlichen Intelligenz“ haben wir in Deutschland – auch in der Ärzteschaft – eine eher defensive und vorsichtige Haltung. Ähnlich wie das vor etwa 20 Jahren bereits beim Thema elektronische Gesundheitskarte eGK war. Aber nicht nur in Deutschland gibt es Skepsis. Auch wenn man sich z. B. angloamerikanische Filme und Bücher zu diesem Thema bis heute anschaut, egal ob der Terminator von 1984 oder Matrix von 1999 oder Ex Machina von 2015: All dies sind Filme und/oder Bücher, die im Grunde genommen die Entwicklung der sogenannten künstlichen Intelligenz als Bedrohung ansehen (Abb. 1). Hier in erster Linie in Form entweder von digitalisierten Persönlichkeiten oder von Robotern, die noch physisch irgendwie zu fassen sind. Allen ist gemeinsam: Immer endet es tragisch und negativ. Wir gehen mehrheitlich tendenziell eher davon aus, dass wir auf lange Sicht durch künstliche Intelligenz bedroht sind. Nichts oder wenig Positives ist langfristig zu erwarten?

Mustererkennung

Der erste wichtige Punkt ist, dass wir heute besser denn je Muster erkennen können. Zum Beispiel beim EEG oder EKG. Beim EEG suchten wir beispielsweise bereits während meiner Doktorarbeit nach Mustern [2]. Dazu visualisierten wir die entdeckten komplexen Muster auf einem Kreis, damit Ärztin oder Arzt bestimmte Symptome auf den ersten Blick erkennen und dadurch leichter auf eine wahrscheinliche Erkrankung schließen konnten [3–5] (Abb. 2). Eines der Muster entspricht zum Beispiel einem großen Schlaganfall, der eher zentral gelegen ist, ein anderes eher einer Epilepsie etc. Vor allem aber waren wir auf der Suche nach physiologischen EEG-Mustern (Biorhythmen) im Schlaflabor im vigilanten Zustand von Probanden. Denn diese als Muster automatisiert zu entdecken und zu quantifizieren, war der eigentliche Fortschritt unserer und vieler weiterer Forschungsarbeiten dazu weltweit. Das, was sich sowieso physiologisch rhythmisch verändert, sollte quasi wie das Tara bei der Waage von den beobachteten Signalen abgezogen werden, die sich durch eine neue Pharmakotherapie ergeben.

Expertensysteme

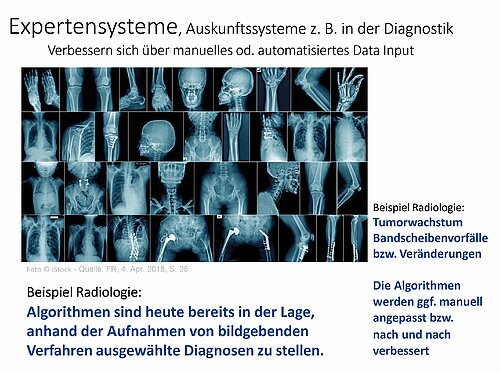

Der nächste Schritt reicht von der Mustererkennung zu den Expertensystemen. Das heißt wir schauen nicht nur nach Mustern und ziehen daraus eigene Schlussfolgerungen, sondern von uns möglichst sorgfältig mit Experten aus IT und Medizin erstellte Algorithmen sollen entdeckte Muster auch interpretieren. Zum Beispiel könnten Symptome wie Bauchschmerzen und Fieber erfasst und mit Laborwerten sowie bildgebenden Verfahren etc. kombiniert und auf einen Computer übertragen werden. Ein Expertensystem des Computers macht uns dann einen Vorschlag für ein oder zwei wahrscheinliche Erkrankungen. Bei bildgebenden Verfahren ist dies quasi schon Standard (Abb. 3). Hauptsymptome wie Bauchschmerz sind dabei oft besonders schwierig einzuordnen, weil diese eben zu unglaublich vielen verschiedenen Krankheiten passen. Ein anderes hilfreiches Beispiel von Expertensystemen ist die Beurteilung der Wechselwirkung von Medikamenten untereinander, die bei vier, fünf oder mehr gleichzeitig gegebenen Präparaten mit dem ärztlich-menschlichen Verstand kaum noch oder eher gar nicht mehr richtig eingeschätzt werden können. Schon unter der Annahme von genau nur einer Wechselwirkung eines Medikamentes auf ein anderes führt das bei vier Präparaten bereits zu zwölf Interaktionen: [n*(n-1) lautet die Formel, nach der man die theoretisch denkbare Anzahl von bidirektionalen Verbindungen zwischen n Systemen berechnet]. Expertensysteme als Auskunftssysteme mit Warnhinweisen zum Beispiel auf Allergien bei ASS sind ja schon fast Standard in Praxis- und Krankenhausinformationssystemen. Weil die Wechselwirkungen bei Krebsbehandlungen oft so komplex sind, dass sie auch Spezialisten nicht mehr hinreichend überblicken können, wird dabei kaum noch auf Expertensysteme verzichtet.

„Intelligente“ Informationen erfordern valide Daten

Noch ist nicht absehbar, wohin sich die zunehmend komplexere Mustererkennung gerade bei der Pharmakotherapie oder bei der Analyse von Erkrankungen oder bei der Identifizierung von Tumormarkern etc. entwickeln wird, da zur immer individuelleren Therapie auch eine immer feinteiligere, individuelle Diagnostik gehört, die streng damit gekoppelt sein muss. Dies gilt auch teilweise schon für die pathohistologische Analyse von Erkrankungen oder die mehr oder weniger automatisierte Bilderkennung mittels Handyfotos von Malignomen in der Dermatologie. Die Qualität der Auskunft- und Expertensysteme ist dabei maßgeblich von umfangreichen, validen Daten abhängig. Ohne den Zugriff auf diese Datenbestände werden die unterschiedlichen Nutzen der genannten Anwendungen nicht sichtbar. Daher soll ein neues Forschungsdatengesetz helfen – zum Beispiel durch Verbesserungen beim Datenschutz, dem Zugang und der Auffindbarkeit von Daten für die Forschung und anderes mehr, denn „intelligent“ aufbereitete Informationen erfordern möglichst viele valide Daten [6] (Abb. 4).

Eine Frage der Ethik

Sehr wichtig ist, dass Datensicherheit, Datenschutz und IT-Risiken dabei auch tatsächlich beachtet werden, vor allem die zunehmenden Cybercrime-Attacken. Hinzu kommen mehrere ethische Forderungen. Die am einfachsten zu verstehende ist die nach der gerechten solidarischen Verteilung des Nutzens von KI für alle Bürger. Komplizierter wird es bei der EU-Forderung nach der Nachvollziehbarkeit der Algorithmen, die einer KI zum Beispiel in der Robotik künftig zugrunde liegt. Betrachten wir dazu die sog. neuronalen Netze, die letztlich so etwas wie das Ergebnis der Zusammenarbeit von Algorithmen darstellen. Das bedeutet vereinfacht, wie diese Algorithmen wechselseitig zusammenarbeiten, sich fördern oder hemmen etc. Man spricht bei den neuronalen Netzen dann auch gerne von sog. Black Boxen, weil unser menschlicher Verstand nicht mehr in der Lage ist, den Instanzen innerhalb der neuronalen Netze ab einer gewissen Tiefe zu folgen. Man stelle sich beispielsweise einen Entscheidungsbaum vor, der nach der 2. oder 3. Instanz bereits 20.000 Verästelungen aufweist. Wir brauchen dazu letztlich wieder „Computer, die Computer kontrollieren“. Daher ist es zwar richtig, dass die EU die Nachvollziehbarkeit der Algorithmen und Entscheidungsbäume künftiger neuronaler Netze fordert (XAI = Explainable AI), aber wie das ethisch nachvollziehbar funktionieren soll und wird, kann heute noch niemand schlüssig beantworten. Es reicht nicht aus, nur „Stopp-Signale“ in die ja von Menschen programmierten Algorithmen zu integrieren. Dazu ein kleines Beispiel: Ein Pflegeroboter der Zukunft sieht einen Patienten aus dem Bett fallen, trägt aber bereits einen anderen Patienten. Wie kann oder soll dieser sich nun selbst entscheiden? Soll er den einen Patienten fallen lassen und den anderen vor dem Herunterfallen schützen? Wie priorisiert er also? Leicht lassen sich noch schwierigere Entscheidungen vorstellen. Wir müssen ihm also eine große Menge an Regeln vorgeben, auch ethische. Womit wir wieder bei den zunehmend komplexeren neuronalen Netzen sind.

Was ist nun KI?

Der Begriff Künstliche Intelligenz (KI) oder Artificial Intelligence (AI) hat im Alltag oder umgangssprachlich die eigentlich zugrunde liegenden, wissenschaftlichen Definitionen längst verdrängt (Deep Learning → Machine Learning → AI). Plötzlich ist scheinbar „überall KI drinnen“. Umgekehrt haben sich die Informatik und für uns vor allem die Bio- und Medizininformatik als Methodenwissenschaften innerhalb der Medizin so hoch spezialisiert, dass deren Fachsprache und wissenschaftliche Inhalte Nicht-Experten kaum mehr vermittelbar sind. Daher hier wieder ein Beispiel, wie man sich tatsächliche „Künstliche Intelligenz“ vorstellen kann: Ein Gast sitzt in einem mit KI gesteuerten autonom fahrenden Auto. Dieses Fahrzeug erkennt eine Geschwindigkeitsbeschränkung von 80 Stundenkilometern und hält sich auch zunächst daran. Die meisten von uns am Steuer mögen sagen, okay, da kann ich aber auch maximal 87 fahren oder vielleicht 85, bevor uns ein radargesteuerter Blitzer erfasst, da passiert also schon nichts. Wir gönnen uns eine gewisse Toleranz. Nun beobachtet aber auch das autonom fahrende Fahrzeug, dass es ständig von einer ganzen Reihe von anderen Fahrzeugen überholt wird. Da offensichtlich nichts passiert, wenn jemand ein bisschen schneller fährt, regelt es seine Algorithmen nach. Es justiert seine eigenen Algorithmen und fährt dann eben auch maximal 87 km pro Stunde. Darf oder wie weit darf künstliche Intelligenz künftig selbst ihre Algorithmen justieren?

Sogenannte Large Language Modelle (LLM) sind in der Lage, aus großen Datenmengen neue Inhalte zu schaffen. Umgangssprachlich wird daher mittlerweile auch immer häufiger von „generativer KI“ gesprochen, wenn Anwendungen, meist kleinere Apps auf mobilen Geräten, beispielsweise „neue“ Texte, Bilder, Sprachnachrichten oder Videos eigenständig bzw. auf Befehl „generieren“ können, möglichst gleich gut oder gar besser, vor allem schneller als ein normal begabter Mensch. Besonders bedenklich ist das, wenn dabei „Fake“-Informationen mit wahren gematched werden [7] und zum Beispiel Sprachnachrichten und anderes mehr verfälscht und mit krimineller Energie genutzt werden. Der Schritt zu gefälschten Diagnose- und Therapiedaten ist da möglicherweise weniger weit entfernt, als wir uns das vorstellen wollen. Und die Vergangenheit hat leider mehrfach gezeigt, dass auch Forschungsergebnisse immer wieder einmal von überehrgeizigen Forschern geschönt oder „frisiert“ wurden.

Ärztliche Verantwortung

Künstliche Intelligenz (KI) hat nach Einschätzung des Präsidenten der Landesärztekammer Hessen in der Medizin ein entscheidendes Manko: „Es fehlen wichtige Elemente der Arzt-Patienten-Beziehung: Emotionalität und Empathie“, sagte Edgar Pinkowski. „Maschinen können auch keine Verantwortung tragen: Das kann nur der Behandler“ (Trauner/dpa, 11. März 2024). Aus den qualitativ immer besser werdenden Auskunfts- und Expertensystemen ergeben sich aber – nicht zuletzt auch aus haftungsrechtlichen Gründen – maximal daraus resultierende Therapie-„empfehlungen“, denn die Entscheidungen bleiben letztlich in ärztlicher Verantwortung. Das kann und will man auch künftig nicht künstlichen Intelligenzen überlassen. Neben den Chancen dürfen daher die Risiken nicht übersehen werden (Tab. 1). Dazu gehört auch, die Forschungsfolgen im Themenbereich KI zu berücksichtigen.

Folgenabschätzung der KI für die Medizinforschung

Die Präsidiumskommission Ethik der Deutschen Gesellschaft für Medizinische Informatik, Biometrie und Epidemiologie e. V. (GMDS) beschäftigt sich daher seit einigen Jahren mit „Ethischen Fragen in der Medizinischen Informatik, Biometrie und Epidemiologie“.

Auf der diesjährigen Jahrestagung der GMDS findet ein Workshop „KI und Ethik in der biomedizinischen Forschung für Medizin und Pflege“ am 9. Sept. 2024 von 9:00–10:30 Uhr in Dresden statt. Anfang kommenden Jahres soll ergänzend ein Buch der Präsidiumskommission Ethik der medizinisch-wissenschaftlichen Fachgesellschaft GMDS im medhochzwei-Verlag in Heidelberg herausgegeben werden, das aktuell in Arbeit ist: „KI und Medizin – Folgenabschätzung für Forschung und Praxis“ (siehe Buchtipp). Der vorliegende Beitrag erscheint daher hier als Erstpublikation und macht vielleicht die oder den einen oder anderen Leser neugierig auf das große Spektrum an Themen, das darüber hinaus darin abgedeckt wird: KI – „Nutzen“ und „Evidenzbasiertheit“, KI im Einsatz – Digitale Diagnostik, Generative KI und medizinische Dokumentation, Ethische Leitlinien, KI-Governance – Erste KI-Richtlinie in einem Universitätsklinikum in Deutschland, Ethische Implikationen in der praktischen Umsetzung von Digitalisierung und KI im Gesundheitswesen, Forschung und deren Folgenabschätzung, Praxisbeispiele dazu, KI ein Medizinprodukt – inklusive Haftungsfragen und Strafrecht der Anwender und Betreiber im Krankenhaus und weitere Themen mehr.

Neue GMDS-Publikation

A. J. W. Goldschmidt, T. D. Deserno, A. Händel, A. Winter (Hrsg.): KI und Medizin – Folgenabschätzung für Forschung und Praxis

Anfang 2025 erscheint im medhochzwei-Verlag in Heidelberg ein von der Präsidiumskommission Ethik der Deutsche Gesellschaft für Medizinische Informatik, Biometrie und Epidemiologie e. V. (GMDS) herausgegebenes Buch (siehe vorläufiges Cover), in dem das vorliegende, vorab publizierte Kapitel um viele weitere Themen ergänzt wird.

Tab. 1: Neben den weitgehend zweifelsfreien Chancen dürfen die Risiken nicht übersehen werden. Es muss stärker über die Forschungsfolgen im Themenbereich KI nachgedacht werden.

| Hauptchancen (KI + Robotik) | Hauptrisiken (KI + Robotik) |

| in der Prävention (Apps, BGM und vieles mehr) | Fachkräftemangel |

| als Assistenz bei Diagnose und Therapie | Cybercrime |

| für Pflege und Altenbetreuung (AAL etc.) | Fehlerhafte Daten von „sog.“ statt wahren Experten |

| bei Design und Autonomie von Hilfsmitteln | Mangelnde Finanzierung (Investitionen) |

| bei der Arzneimittelentwicklung | Infrastrukturdefizite (Netze ...) |

Univ.-Prof. Dr. med. habil. Andreas J. W. Goldschmidt, Leiter der Präsidiumskommission Ethische Fragen in der Medizinischen Informatik, Biometrie und Epidemiologie der Fachgesellschaft GMDS; Gastwissenschaftler am Institut für Arbeits-, Sozial- und Umweltmedizin der Goethe-Universität Frankfurt/Main, E-Mail: goldschmidt@med.uni-frankfurt.de

Die Literaturhinweise finden Sie hier.